机器人学习目前已经被广(guǎng)泛应用于现实世界,并可以完成精密(mì)的手部、腿部动(dòng)作。但在(zài)动(dòng)态且高速的人(rén)机互动(dòng)中,机器人学习并不常(cháng)见。谷(gǔ)歌选(xuǎn)择(zé)开发(fā)乒乓球(qiú)机器人,正是为了探索这(zhè)类情况下人工智能的可能性。

·使用i-Sim2Real这种方式,在模(mó)拟环境下可以让数年的实时训练在几分钟或几小时内(nèi)完成。

谷歌i-Sim2Real项目乒乓球机器人(rén)与(yǔ)人类训练。本文图片来源:谷歌

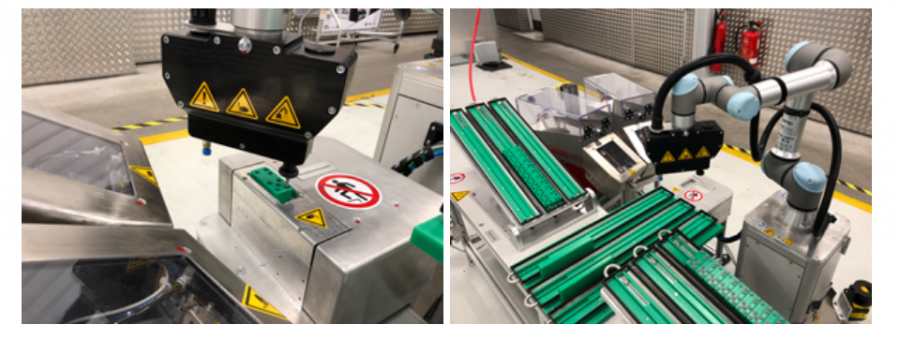

似乎现存(cún)的每一种桌上(shàng)运动中,人工智(zhì)能都立于不(bú)败之地。乒乓球竞技中,谷歌AI同样难逢敌(dí)手。10月18日,谷歌公布其(qí)正(zhèng)在研究的“乒乓球机(jī)器人”项目,在与人类对打时一回合(hé)可(kě)接球340次。目前,谷歌(gē)强(qiáng)调(diào)这只是人类与AI的“合作”,并非击败人类(lèi),但以AI成长的(de)速度,它将很快成为专业选手。

机(jī)器人学习目前(qián)已经(jīng)被广泛(fàn)应用于(yú)现(xiàn)实(shí)世(shì)界(jiè),并可(kě)以完(wán)成精密的手部、腿部动作。但在动态且高(gāo)速的人机互动中,机器人学习并不常见。谷歌选择开发(fā)乒乓球(qiú)机器(qì)人,正是为了探索这类情况下(xià)人工智能的可能性。

解决“先(xiān)有鸡还是(shì)先有蛋”

在这个名为i-Sim2Real的项(xiàng)目中,谷歌的(de)乒乓球机器(qì)人在模拟环境中(zhōng)不断学(xué)习,并将学习成果运用于现实世界,最终(zhōng)可以在一个与人(rén)类的乒乓球接发回合中,接球超(chāo)过三百次。它还能把球送回不同(tóng)的区域,虽然不能精(jīng)确到数字上(shàng),但已经(jīng)足够精确到让(ràng)机器人规划策略,来控制乒乓球的最终目的地。

i-Sim2Real也不仅(jǐn)仅是关于乒乓球机(jī)器人(rén),更是一(yī)种人工智能创造过程(chéng)的方式,在(zài)这个过程中(zhōng),机器学(xué)习模型被教会在虚拟环境(jìng)或模拟中做什么,然(rán)后再应(yīng)用这(zhè)些知识,目标是尽可能长(zhǎng)时间地与人类进(jìn)行接(jiē)球回合而不失误。在现实世界(jiè)中直接与人类玩家进(jìn)行训练既繁琐又(yòu)耗时(shí),当需(xū)要(yào)数(shù)年的试验和错误才能建立一个工作模型时,使用i-Sim2Real这种方式显得十分有效(xiào),它在模拟(nǐ)环(huán)境下可以让数(shù)年的(de)实时训(xùn)练在几分钟或几小时内完成。

这种方式(shì)听起来简(jiǎn)单高效(xiào),但在模拟中机器人并不是万能的。人(rén)类的活动具有(yǒu)一定(dìng)的不(bú)可预测性,并不容易模拟,需要先有人类的行为(wéi)模型作为支撑。而人类(lèi)的(de)行为模型(xíng),又需要与(yǔ)机器人互动获得(dé)。这就陷入了一个“是先有鸡还是(shì)先有蛋(dàn)”的死循(xún)环。

i-Sim2Real解决这一鸡和蛋问题的方法,是使用一个简单的人类(lèi)行为模型作(zuò)为(wéi)近(jìn)似起点(diǎn),并让机(jī)器人(rén)在模拟训练和(hé)现实训练之间交替学习。在每次迭代中,都会细化人类行为模型和策略。在机器人接(jiē)近(jìn)人类行为(wéi)的过程中,初期(qī)的不理想(xiǎng)是可以(yǐ)接(jiē)受的(de),因为机器人也只是刚刚开始学习(xí),之后每一场(chǎng)比赛都会收集(jí)更(gèng)多真实的人类数据(jù),提高准(zhǔn)确性,让AI学(xué)到更(gèng)多。

i-Sim2Real的训练方法。

GoalsEye:通过自我监(jiān)督来自主(zhǔ)练习

除了i-Sim2Real这种模拟与现实交替进行(háng)的方法,研究人员也在探索只使用现实的数据学习的方法,即GoalsEye项目(mù)。

一开始,模仿学习(IL)为研究(jiū)人员提供了一种简单(dān)而稳定(dìng)的思路,但它需要人类行为进行演示,并且机器人的技术无法超(chāo)过演示者的水平。同(tóng)时,当演示(shì)者拥有在高速(sù)环境下精确接球的能(néng)力(lì)时,收(shōu)集(jí)其(qí)数据具有一定挑战性,而且(qiě)在(zài)刚开始时可能非常低效(xiào)。因此研究人员尝试了一种结合(hé)最近行(háng)为进行重复的方法(fǎ),从一个小(xiǎo)的、结构薄弱的、非目(mù)标数据集开始,不(bú)断学(xué)习(xí)精确定位目(mù)标(biāo)的策略。

这种方(fāng)法使得在训练的过程中,机器(qì)人的(de)自主学习能力显得至关重(chóng)要。研究人员(yuán)设(shè)置了一个(gè)强(qiáng)调(diào)精度的乒乓球任务,要求(qiú)机器人将球返(fǎn)回(huí)到桌子上的任意目标位置。机(jī)器人(rén)可以通过自我监督来(lái)实现(xiàn)自主练(liàn)习。例如,机器(qì)人(rén)可以设置随机目标,“击中左后角”或“将(jiāng)球从右侧过网”,并尝试使用当(dāng)前掌握的策略来实现这些目标,从而不(bú)断改(gǎi)进。所有尝试都会(huì)记录并(bìng)添加(jiā)到不断扩展的数据(jù)集中。这种自主练习是反复进行的,机器人通过不(bú)断的设(shè)置随机目标并(bìng)尝试目(mù)标(biāo),从而(ér)扩(kuò)展训练数(shù)据,调整策略。

GoalsEye策略旨在实现直径20厘米的目标(左)。人类玩家瞄准同一个目(mù)标(右)。

GoalsEye的训(xùn)练方法。

其效果也(yě)是显而易见的,在进行(háng)最初的2480次人类行为演示后,机器人只在9%的情况下(xià)能准确地达到距(jù)离目标30厘米以内的目标。然而,当机器人又自主练习了大约13500次(cì)后,达到(dào)目标(biāo)的准(zhǔn)确率上升到43%。同时(shí),演示(shì)数量的提升(shēng)提(tí)高了后(hòu)续自我练习的(de)效率,这说明,计算(suàn)时间、成本等因素后,演示可以适当替换(huàn)自我练习,从而更(gèng)高效的进行训练(liàn)。

在这两个(gè)使用(yòng)机器人乒乓球(qiú)研究平台的互补项(xiàng)目中,i-Sim2Real可以在模拟与现实中交替学(xué)习策略,而GoalsEye则(zé)证明,从(cóng)现实世界的非结构化数(shù)据中学习,结合自我训练,对于(yú)在精确且动态的要求中(zhōng)学习(xí)目标条件策(cè)略是有效的。