常(cháng)见的机器学习(xí)算(suàn)法

诞生于1956年的人工智能,由于(yú)受到智能算法、计算速度、存储(chǔ)水(shuǐ)平等因素的影响,在六十多年的发(fā)展过程中(zhōng)经历了多次高潮(cháo)和低谷。最近(jìn)几年,得(dé)益于数据(jù)量(liàng)的上涨、运算力的提(tí)升,特别(bié)是机器学习(xí)新(xīn)算法的出现,人工(gōng)智(zhì)能迎来了大(dà)爆发的时代(dài)。

提到机器学习这个词时,有些人(rén)首先想到的可能是科幻电影里的(de)机器人。事实上,机器学习是一门多领域交叉学科,涉及概率论、统计学、算法复杂度理论等多门学科。专门研究计算机如何模拟或(huò)实现人类的(de)学(xué)习(xí)行为,利用数(shù)据或以往的经验,以此(cǐ)优化(huà)计算机程序的(de)性能标准(zhǔn)。

根据学习任务的不(bú)同(tóng),我们可以将机器学习分(fèn)为监督学习(xí)、非监督学习、强化(huà)学(xué)习三种类型,而(ér)每种(zhǒng)类型又对应着一些算法。

各种算法以及对应的任务(wù)类型

接下(xià)来就简单介绍几种常(cháng)用的机(jī)器学习算法及其应用场(chǎng)景,通过本篇文章大家可以对机器学习的常用算法有个常识(shí)性(xìng)的认识(shí)。

一、监督学习

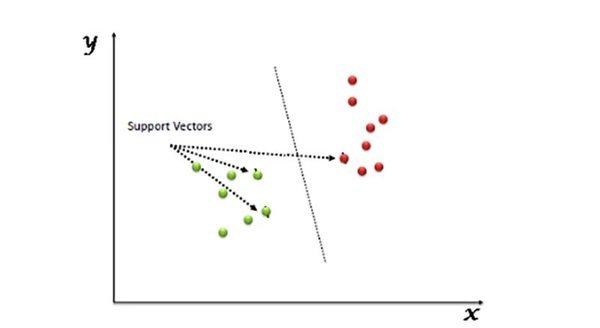

(1)支持向(xiàng)量机(Support Vector Machine,SVM):是(shì)一类按监督学习方式对数据进行二元(yuán)分类的广义线性分类器(qì),其(qí)决策(cè)边界是对学习样本求解的最大边距超平(píng)面。例(lì)如,在(zài)纸上有两类线性可(kě)分的(de)点(diǎn),支持向量机(jī)会寻找一条(tiáo)直线将这两类(lèi)点区分开来,并且(qiě)与(yǔ)这些(xiē)点的距离都(dōu)尽可能远。

优点:泛化(huà)错误率低,结果易解释。

缺点:对大(dà)规模训练样本难以实施,解决多(duō)分类问题存在困难,对参数调节(jiē)和核函数的选择敏(mǐn)感(gǎn)。

应用场景(jǐng):文本分类(lèi)、人像识(shí)别、医学诊(zhěn)断等。

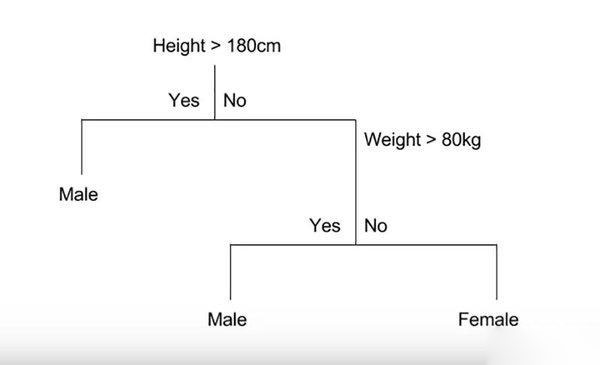

(2)决策树(shù)(Decision Tree):是一个预测模型,代表的是(shì)对象属性与对象值之间的(de)一种映射关系。下图是如(rú)何在(zài)决策树中建(jiàn)模的(de)简单示(shì)例:

优点(diǎn):易于理(lǐ)解(jiě)和(hé)解释,可以可(kě)视化分析,容易提取出规则;能够处理不(bú)相关的(de)特征。

缺点(diǎn):对缺失数据处(chù)理比较困难。

应用场景:在决策过程应用(yòng)较多(duō)。

(3)朴(pǔ)素贝叶斯(sī)分类(Naive Bayesian classification):对于给出的待分(fèn)类项,求解(jiě)此项(xiàng)出现的条件下各个类别出现的(de)概率,哪(nǎ)个最大,就(jiù)认(rèn)为(wéi)此待分类属于哪个(gè)类别。贝叶斯(sī)公式为:p(A|B)= p(B|A)*p(A/p(B),其中P(A|B)表(biǎo)示(shì)后验概(gài)率,P(B|A)是似然值,P(A)是类(lèi)别的先验概率,P(B)代表预测器(qì)的先验概(gài)率。

优(yōu)点:在数据(jù)较少的情况(kuàng)下(xià)仍然有效,可以处理多类别问题(tí)。

缺点(diǎn):对输入数(shù)据的准备方式(shì)较(jiào)为(wéi)敏感(gǎn)。

应用场景(jǐng):文本分类、人(rén)脸(liǎn)识别、欺诈检测。

(4)k-近邻(lín)算法(K-Nearest Neighbor,KNN):是一种基于实例的学习,采(cǎi)用测(cè)量不同特(tè)征值之间的(de)距(jù)离方法(fǎ)进行分类。其基本思(sī)路是:给定一个训练样(yàng)本集,然后输入没有标签的新数据,将新数据的每个特征与样本集中(zhōng)数据对应的特征进行比较,找(zhǎo)到最邻(lín)近的k个(gè)(通常(cháng)是不大(dà)于20的(de)整(zhěng)数)实例,这k个实(shí)例的多数属于(yú)某个类(lèi),就把(bǎ)该输入(rù)实例分类到这个类中。

优点:简(jiǎn)单、易于理解、易于实现,无需估计参数。此外,与朴素贝(bèi)叶斯之类(lèi)的算(suàn)法比,无数据(jù)输入假定、准确度高、对异(yì)常数(shù)据值不(bú)敏感(gǎn)。

缺点:对于训练数据依赖程度比较大,并且缺少(shǎo)训练阶段(duàn),无法应对多样本。

应用场景:字符(fú)识别、文本分类、图(tú)像识别等领域。

二、非监督学习

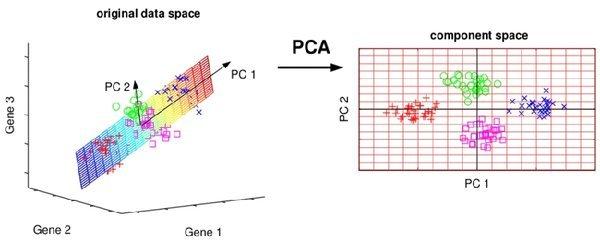

(1)主成分分析(Principal Component Analysis,PCA):是一种(zhǒng)统计方法。其主要思想是将n维特征映(yìng)射到k维(wéi)上,这k维是全新(xīn)的正(zhèng)交特征也被称为主成分(fèn),是在原有n维特征的基础上重新构造出(chū)来的k维特征。

优点:降低(dī)数据的(de)复(fù)杂性,识别(bié)最重要的多个特征。

缺点:主(zhǔ)成分各个特征(zhēng)维度的含(hán)义具有一定的模糊性,不(bú)如原始样本特征的(de)解释(shì)性强;有可能损失有用的信息。

应(yīng)用(yòng)场景:语音、图像、通信的分(fèn)析处理。

(2)奇异值分解(Singular Value Decomposition,SVD):可以将一个比较复杂的(de)矩阵(zhèn)用更小更简单的几个子矩阵的相乘来表示,这些小(xiǎo)矩阵描述的是(shì)矩阵的重要的(de)特性。

优点:简(jiǎn)化数据,去除(chú)噪声点(diǎn),提高算法的结果。

缺点(diǎn):数(shù)据的转换可能难以理(lǐ)解。

应用场景:推荐系统、图(tú)片压缩等(děng)。

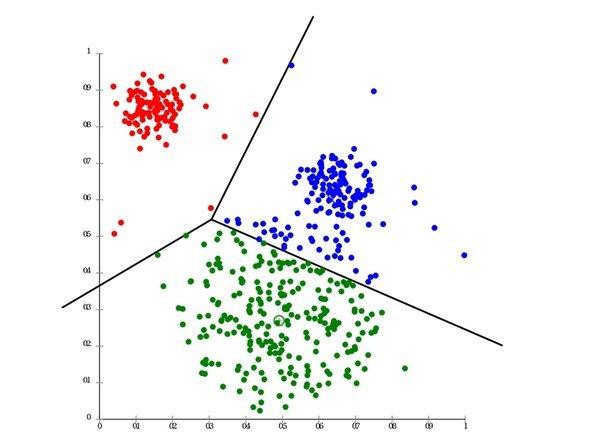

(3)K-均值聚类(K-Means):是一种迭(dié)代求解的聚类分析算法,采用(yòng)距(jù)离作为相似性(xìng)指标(biāo)。其(qí)工(gōng)作(zuò)流程是随(suí)机确(què)定(dìng)K个对象作为初(chū)始的(de)聚(jù)类中心(xīn),然后计算每个(gè)对象与各个种子聚(jù)类中心之间的距离,把每个对象分配给(gěi)距离(lí)它最近的聚(jù)类中心。

优点(diǎn):算法简单容易实现。

缺点:可能收敛到局部最小(xiǎo)值,在大规模数据集上(shàng)收敛较(jiào)慢。

应用场景:图像处理、数据分析以及(jí)市场研究等。

三(sān)、强(qiáng)化学(xué)习

Q-learning:是一(yī)个基于值(zhí)的强化(huà)学习算法,它(tā)根据动作值函数评(píng)估应该选择哪个动作,这(zhè)个函数决定了处于某(mǒu)一个特定(dìng)状态以及在(zài)该状态下采取特(tè)定动作的奖励期望值。

优点:可以(yǐ)接收更广(guǎng)的数据范围。

缺(quē)点:缺乏通用性。

应用场(chǎng)景:游(yóu)戏开发。

以(yǐ)上就是文(wén)章的全部内容,相信大家(jiā)对常用(yòng)的机器学习(xí)算法应该有了大致的(de)了解。

现(xiàn)如今(jīn),我们越来越多地看(kàn)到机器学习(xí)算(suàn)法为人(rén)类带来的实际价值,如它们(men)提供了关键的(de)洞(dòng)察力(lì)和(hé)信息来报(bào)告战略(luè)决策(cè)。可以肯定的(de)是,随着机(jī)器学习越来越(yuè)流行(háng),未来还将出现(xiàn)越来越多(duō)能很好地处理任务的算法。